Maîtrisez Spark pour le Big Data avec Scala

Un programme pratique pour devenir Ingénieur Spark Scala en moins de 3 mois !

Vous souhaitez travailler dans le Big Data ? Vous souhaitez vous réorienter vers un parcours de Data Engineer ?

Si c'est le cas, alors vous savez déjà probablement que la maîtrise de Spark est obligatoire dans quasiment toutes les missions Big Data, spécialement pour les postes de Data Engineer ! Peut-être vous avez passé des entretiens, et les recruteurs ont apprécié votre profil, mais lorsqu'ils ont constaté que votre niveau sur Spark et Scala n'était pas satisfaisant, vous êtes passés à côté de la mission.

Si vous faites un tour sur les appels d'offres et les offres d'emploi, vous remarquerez que le niveau de maîtrise minimum attendu par les clients pour Spark c'est le niveau "confirmé". Avec le volume de données que les entreprises doivent gérer aujourd'hui combiné au niveau de complexité de l'infrastucture informatique (DevOps, DevSeCoPS, Cloud Computing, Cluster computing, On-premise, etc...), elles ne peuvent plus se permettre de recruter des profils moyens, des profils qui ont une connaissance partielle du traitement de données à large échelle, de la programmation, ou de l'infra.

Si vous voulez réussir votre carrière dans le Big Data aujourd'hui, que ce soit en tant que Data Engineer, Data Analyst, chef de projet Big Data, Data Architecte, ou Consultant Big Data, vous devez impérativement vous professionnaliser sur Spark.

Malheureusement, le problème c'est que lorsqu'on veut se professionnaliser sur Spark, comme sur toute autre technologie du Big Data, on se heurte à 3 obstacles majeurs :

Obstacle #1 : la mise en place de l'infra Big Data nécessaire

En effet, comme toutes les autres technologies du Big Data, Spark s'exécute dans un cluster. Il faut donc connaître l'infrastructure d'un cluster informatique, comprendre les modes d'installation de Spark, et s'équiper en cluster ou trouver un cluster dans lequel s'entraîner, ce qui est juste non-envisageable, ou au mieux pas évident...

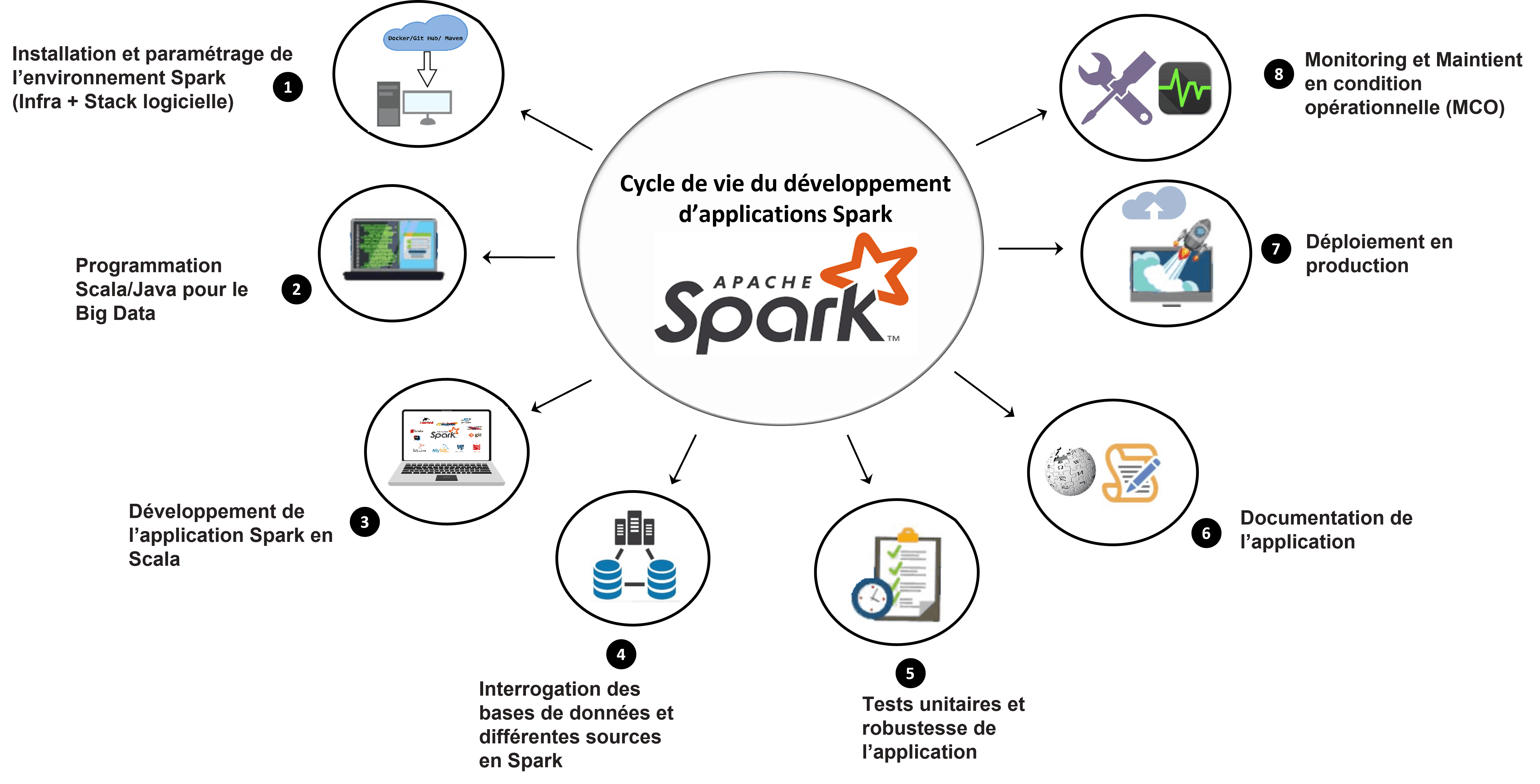

Obstacle #2 : le cycle de vie du développement d'une application Spark

Les applications Spark ont un cycle de vie très particulier. Il faut déjà savoir concevoir l'application, ensuite savoir la développer dans un langage de programmation spécifique, puis la rendre robuste et tolérante aux pannes, et enfin la déployer en production dans un environnement aussi hostile qu'un cluster !

Conséquence, Spark évolue dans un écosystème de technologies complexes et peu connues du grand public, qui fait que si on souhaite déployer les applications Spark qu'on apprend à développer, il faut également maîtriser tout un panel de technologies qui requiert chacune un savoir-faire particulier, notamment : Git, GitHub/GitLab/Azure DevOps, Nexus, Maven, SBT, XML, JUnit, Scala, Java, Log4J, JDBC, ODBC, ThriftServer, Hosebird, IntelliJ, etc... Il ne suffit pas uniquement de maîtriser les API de Spark.

Ainsi, la triptique très commune "Spark RDD => Spark SQL => Spark Streaming" qui structure le programme de quasiment toutes les formations Spark du marché n'est pas suffisante pour opérer à un niveau professionel avec Spark. Si vous voulez pouvoir utiliser Spark à un niveau professionnel dans le contexte actuel, en plus de la maîtrise des API natives de Spark, vous devez également maîtriser l'écosystème de technologies autour de Spark.

Obstacle #3 : le versioning des technologies de l'écosystème Big Data

Le troisième obstacle et non des moindres est le versioning ! En moyenne, une nouvelle release de Spark et des technologies de l'écosystème Big Data avec lesquels Spark fonctionne sort tous les 6 mois. Cela signifie qu'à peine s'être concentré sur une version que celle-ci est déjà obsolète :(

Tiens ! Juste à l'écriture de cette page, la communauté Open source venait de sortir la version 3 de Spark, la version 2.13 de Scala, la version 8 de Java, la version 16 du JDK, et la version 2.14 de l'API Jackson Databind, indispensable à Spark pour la sérialisation des données.

Vous devez donc prendre en compte les évolutions de chaque technologie de l'écosystème Spark lors du développement de vos applications Spark, sous peine de voir des incompatibilités entre différentes versions ruiner vos efforts de développement. Par exemple, si on développe en Spark 3.0, quel langage de programmation est approprié ? Dans quelle version de ce langage ? Cette version est-elle compatible avec la dernière version de Kafka ? de Hive ? de la JVM ? Quelle version d'OS supporté ?...etc.

Vous voyez qu'il ne suffit pas de savoir développer en Spark. Dès qu'on est dans une logique professionnelle, il faut savoir combiner les versions des technologies autour de Spark compatibles entre elles. Celà rajoute une difficulté supplémentaire dans la courbe d'apprentissage de Spark, déjà très périlleuse...

Ce sont toutes ces difficultés qui font qu'il est de plus en plus difficile pour les recruteurs de trouver des profils Spark compétents, qui peuvent les aider à résoudre les problématiques Big Data que leur entreprise rencontre avec l'infrastructure IT dont elle dispose. Et c'est cette rareté des profils Big Data maîtrisant Spark qui fait que leur salaire ou leur TJM soit si élevé !

Selon les estimations des jobboard indeed et Talent, les salaires des professionnels Spark Scala dans le marché francophone (France et la province francophone du Canada, le Québec) sont les suivants :

Comme vous pouvez le voir, le salaire lorsque vous maîtrisez Spark Scala est quasiment de 60 000 € en France, et il y'a plus de 472 postes à pourvoir (rien qu'en Ile-de-France). Au Québec, le salaire démarre à $105 000 CAD (Dollars Canadiens), et il y'a plus de 111 postes à pourvoir (rien qu'à la province du Québec, sans tenir compte de toutes les autres appelations).

Vous voyez qu'investir dans vos compétences Spark maintenant c'est garantir une sécurité financière pour vous et votre famille dans le futur. C'est avoir le contrôle sur votre carrière, et c'est avoir le choix sur les missions sur lesquels vous souhaitez travailler !

Notre formation "Maîtrisez Spark pour le Big Data avec Scala" vous professionnalisera sur Spark en moins de 3 mois !

La formation vous rendra capable de développer des applications Big Data Spark à un niveau professionnel en à peine 3 mois et uniquement avec l'aide de votre simple PC !

Qu'est ce que cela veut dire ?

Cela veut dire qu'à la fin de cette formation, vous serez capable de développer des applications robustes avec Spark, qui exploitent des giga octets de données, et vous serez capable de les déployer en production, tout cela à partir de votre simple PC et rien d'autre !

Il ne s'agit donc pas de la maîtrise des API de Spark uniquement, mais également de la maîtrise de tous les outils qui entrent dans le cycle de vie d'une application Big Data développée en Spark, notamment : Apache Maven, IntelliJ, Git, GitHub, Scala, Java, XML, MarkDown, Log4J, JUnit, Spark SQL, JDBC, ODBC, ApacheThrift Server, et Shell.

La formation couvre les 8 activités du cycle de vie d'une mission de Data Engineering avec Spark telles qu'illustrées par l'image suivante :

Programme détaillé de la formation

La formation est structurée en 8 parties, une pour chacune de ces activités et totalise 71 sessions vidéo pratiques d'une durée de 38 h 17 min. Les 38 h 17 min sont réparties selon le programme suivant :

Les projets à réaliser dans la formation

Pour vous permettre d'asseoir les acquis pédagogiques et les compétences que vous aurez obtenus dans cette formation, la formation est illustrée par 7 projets complets avec des jeux de données réels que vous aurez à réaliser tout au long de celle-ci. Voici la liste de ces projets :

Vous pouvez retrouver l'ensemble de ces projets dans le répertoire GitHub des éditions Juvénal & Associés.

En plus, vous recevez en bonus de la formation :

Obtenez la formation aujourd'hui pour 399 € seulmement !!!

La formation coûte normalement 499 €. Mais pour vous encourager dans votre démarche de vous professionnaliser dans le Big Data et sur Spark en particulier, nous vous offrons la possibilité de vous la procurer au tarif avantageux de 399 €, soit une réduction de 20% !! Vous avez également la possibilité de vous la procurer en payant 4 tranches de 120 euros chacune. Profitez maintenant ! Cliquez sur le bouton suivant pour vous inscrire à la formation et faites partie des professionnels Spark tant convoités par les recruteurs !

100% Satisfaction Garantie

Paiement sécurisé

money back

100%

14 JOURS GARANTIE

Garantie 100% Satisfait ou remboursé de 14 jours

Cette formation est la meilleure formation Spark de toute la francophonie. Assurément, elle vous aidera à développer des compétences solides en Spark. Nous en sommes fermement convaincus. C'est pourquoi nous l'offrons avec une garantie 100% satisfait ou remboursé de 14 jours. En d'autres termes, si dans les 14 jours qui suivent votre inscription, vous n'êtes pas satisfaits de la formation, écrivez-nous à contact@data-transitionnumerique.com et nous vous rembourserons intégralement sans aucune discussion ! A la différence des autres garanties du marché, la nôtre n'est entachée d'aucune condition !!

Ils nous font confiance

Beaucoup de clients institutionnels (universités, grande écoles d'ingénieur, bibliothèques, collectivités, ministères), et de clients privés (entreprises) nous font confiance pour fournir cette formation à leurs salariés. Voici quelques unes de nos reférences :

Que disent nos étudiants par rapport à la formation ?

Abel traore

DATA SCIENTIST

"Je me suis inscrit à la formation 'Maîtrisez Spark pour le Big Data avec Scala' parce qu'à travers la maîtrise de spark, je voulais pouvoir terminer mon projet personnel sur le traitement de données streaming et maîtriser la réalisation d'un projet big data classique du début à la fin. Ce que j'ai apprécié le plus dans la formation c'est la clarté des explications, le sens pédagogique et la disponibilité du mentor à répondre à mes questions"

HALIBOU YACOUBOU

DATA ENGINEER

"Je me suis inscrit à la formation 'Maîtrisez Spark pour le Big Data avec Scala' parce que je souhaitais me reconvertir en Big Data, vers le métier de Data Engineer. J'ai été très satisfait ! J'ai vraiment beaucoup aimé la pédagogie et la manière d'expliquer du formateur. Il maîtrise vraiment son domaine"

Juvénal CHOKOGOUE

A propos du formateur

Juvénal CHOKOGOUE est spécialisé sur les sujets de valorisation des données à large échelle depuis 2011. Il est également l'auteur des ouvrages "Hadoop - Devenez opérationnel dans le monde du Big Data" paru chez les éditions ENI et "Maîtrisez l'utilisation des technologies Hadoop" paru chez les éditions Eyrolles. La valorisation des données à large échelle avec Spark n'a aucun secret pour lui.

100% satisfaction garantie

Paiement sécurisé

100% Satisfaction Garantie

Vous êtes totalement protégés par notre garantie 100% Satisfait ou Remboursé. Vous ne prenez aucun risque. Si dans les 14 jours, vous ne sentez pas que vous progressez vers le niveau d'un Data Engineer confirmé sur Spark, faites-nous le savoir et nous vous rembourserons promptement sans aucune question.

Questions les plus fréquemment posées

Juvénal, je souhaite payer la formation en plusieurs tranches. Est ce possible ?

est ce que la formation est un bon investissement pour moi ?

c'est bien beau, mais est-ce que vous remettez un diplôme à la fin de la formation ?

Juvénal, je ne sais pas programmer en Scala :(

Les temps sont durs ! La formation est bonne mais je la trouve un peu cher quand même !

Quel PC me faut-il pour suivre cette formation et réaliser ses 7 projets ?

Que se passe t'il si après avoir acheté la formation je me rends compte que ce n'est pas ce que je recherchais ?

Juvénal, je n'ai pas le temps !

je vois que la formation est en ligne. Combien de temps ai-je accès à la formation ?

P.S.: Maîtriser Spark en scala fera de vous un professionnel confirmé du Big Data, un as de la gestion des projets Big Data de votre entreprise. Si vous avez vraiment à coeur de travailler dans le Big Data et devenir Data Enginer, alors cette formation est un excellent investissement pour vous.

Je vous garantis que la maîtrise de Spark changera votre avenir professionnel et vous ouvrira un champs de possibilités financières et professionnelles que vous n'imaginez même pas. Je le dis d'expérience car j'exerce à mon compte en tant que Tech Leader Big Data depuis 2015.

Faites-moi confiance, inscrivez-vous et obtenez la maîtrise dont vous avez besoin en Spark pour devenir un professionnel confirmé du Big Data. Le coupon de réduction va expirer dans quelques temps.